[Choualbert Einstein] - L'Intelligence Artificielle

Bonjour à tous,

Le premier thème retenu pour cette série de box est l'intelligence artificielle.

Je rappelle le but de la box:

Vous posez vos questions sur le thème, les chouals vous répondent.

L'intelligence artificielle est un domaine de l'informatique qui a pour but de faire réaliser à un programme des tâches habituellement associées à l'intelligence humaine:

Raisonnement, Perception, Apprentissage, Créativité, Décisions

C'est un domaine qui existe depuis les années 50, mais dont la popularité a explosé depuis une bonne dizaine d'années.

Clarification de quelques termes:

- Machine Learning : sous domaine de l'IA ou le programme "apprend" à réaliser une tâche grâce à des exemples

- Deep Learning : sous domaine du machine learning où les programmes sont constitués de réseaux de neurones artificiels ( de grande taille = profond )

Il y a beaucoup de questions techniques, éthiques et philosophiques qui se posent, à vous de d'orienter la discussion en choisissant les bonnes. La qualité de la box dépend de votre participation

Strawpoll pour le prochain thème : https://www.strawpoll.me/16947366

L'image de la box vient de Nvidia

Cette question est plus portée sur le thème philosophique que celui de la science, mais est-ce qu'il est possible qu'un jour une machine puisse être amenée à faire des choix en fonction d'une base morale/immorale ? Est-ce que le deep-learning est assez poussé pour permettre à une intelligence artificielle de comprendre des principes abstraits tels que le bien et le mal ? Par exemple, pour une voiture à pilote automatique, dans un cas où elle doit choisir entre sauver son conducteur et tuer un groupe d'enfant sur le bas côté de la route, ou laisser ce groupe survivre en dépit du conducteur, sur quoi va-t-elle baser son choix ?

Est-ce que ça ne serait pas ça, la limite de l'IA ?

En philo la réponse à ce genre de dilemne dépend de l'approche qui en est faite, il me semble que Science4All avait réalisé une bonne vidéo à ce sujet avec l'approche utilitariste (si ça parle à qqn sinon je te retrouve ça quand je pourrai). Du coup je pense que ça dépend du mode de raisonnement de l'IA (en admettant quelle puisse appréhender ces situations au moins de la même manière que nous).

Oui je pense que c'est bien ça le problème majeur. Nous mêmes, créateurs, sommes limités par des notions telles que la moralité, l'empathie, le bien et le mal etc. Donc quand le créateur est limité, est-ce que cette même limite est imposée à sa création ? Après on sort pas mal de l'aspect scientifique de la box.

SI tu lui donnes suffisamment d'exemple de ce qui est bien / morale et mal / immorale en théorie c'est faisable d'apprendre à une IA à faire la différence, après est ce que ça voudra dire qu'elle a vraiment identifié le principe abstrait c'est dur à dire, ça dépend de ce que tu veux dire par savoir / comprendre.

Est ce que si je me trompe jamais entre chien et chat ça veut dire que j'ai compris ce que c'est qu'un chat?

comprendre c'est être capable d'abstraire, je vois pas pourquoi on détacherait d'un coté la compréhension humaine et de l'autre la compréhension logicielle.

Comprendre ce qu'est une chaise, c'est avoir abstrait l'idée que c'est un objet sur lequel on peut s'asseoir en étant surelevé par rapport au sol. Si une ia arrive a reconnaitre une chaise, qu'elle ai des pieds, un seul, un dossier ou non, etc, alors oui, elle a compris ce qu'est une chaise.

Quand on ne peut faire aucune différence entre deux comportements, c'est que le comportement est identique.

la seule chose qui écarte pour le moment les IA du monde vivant, c'est l'absence de l'experience physique (qui est possible a gérer avec un robot par exemple), et l'absence d'instinct de survie. Mais je vois mal comment on pourrait créer un instinct de survie. Ca supposerait de créer un réseau neuronal qui a pour but de toujours garder en vie le réseau neuronal quel qu'en soit le cout, ce qui casse les lois de la robotique avant même d'avoir commencé a construire une intelligence artificielle digne de ce nom...

"Quand on ne peut faire aucune différence entre deux comportements, c'est que le comportement est identique." Le comportement est identique sur les points que t'as testé, mais tu peux pas tout tester, donc c'est normal d'avoir des doutes.

Disons que ta base de données est biaisée, les photos de chat sont toujours en intérieur et les photos de chien sont en extérieur. Ton IA apprend à faire la différence entre les deux. Tu peux croire qu'elle a appris le concept de chat alors qu'elle a appris à reconnaitre intérieur / extérieur.

Là c'est un exemple simple mais y'a surement des cas où on peut pas trop s'en rendre compte.

Techniquement, la base de l'éducation humaine, c'est une répétition d'acte et de conséquence. Une répétition d'information pour t'inculquer un modèle de comportement. Il est selon moi possible de réaliser exactement la même chose pour une machine.

Maintenant, dans les faits, l'humain, même s'il se base sur son propre modèle de comportement et sur son vécu, est capable de faire des choix en théorie irrationnel. C'est en ça je pense que la question se pose en effet. Si je doit prendre l'exemple d'IRobot par exemple et de l'accident de Will Smith : la machine à procéder à un calcul de probabilité de survie et à choisi celui qui avait rationnellement le plus de chance de survie.

Pour le cas d'une machine comme un pilote automatique, il serait peut être plus judicieux d'avoir un comportement rationnel, basé sur des schémas de comportement prédéfinis. Mais cela voudrais dire lui avoir appris chaque scénario possible et imaginable.

Tu pars du principe que "le bien" et "le mal" existent. Or c'est juste une question de point de vue. Le bien et le mal n'existent que selon des lois sociales. C'est ce qui a permis à des gredins de transformer un bot de Microsoft en créature raciste.

Tout le problème c'est qu'on appréhende l'intelligence artificielle avec antropomorphisme. Mais une IA n'est pas une créature humaine numérisée. C'est un ensemble de "savoir" qu'un système informatique apprend à gérer via des algorithmes auto-générés.

Le problème est sémantique. Quand on entend "Intelligence artificielle", on entend "Intelligence". Mais ça n'est pas de l'intelligence. C'est un gros stock de contenu.

A la différence qu'un chat et un chien se distingue pas leur adn (pour la jouer précise). Le bien, le mal, ne se distingue que par l'expérience de l'individu.

Pour distinguer le bien du mal, il faut apprendre l'empathie, il faut apprendre la douleur, il faut apprendre des centaines d'autres choses qui permettent à un être humain de différencier cela.

Hors, on ne sait déjà pas comment, nous, humain, sommes capable d'empathie. On sait ou cela se situe dans le cerveau, les neurones miroirs, mais c'est tout.

Je ne vais pas relancer le débat sur le terme IA, mais quand on aura décoder le cerveau humain, on pourra en créer un, et de ce fait, créer une véritable intelligence artificielle.

Haaaaa, enfin, quelqu'un qui à le même avis que moi sur l'idée d'appeler ces algorithmes IA. Merci, j'ai eu de sacré débat ici sans que personne n'ait le même avis.

Où est l'intelligence quand cela suit un algorithme? Quand tu fais une "IA", tu détermines ce qu'elle va faire. Jouer au jeu de GO par exemple. Cette IA se base sur les règles, qu'on lui donne, pour jouer. Elle est incapable de faire autre chose. Quel est l'intelligence?

L'intelligence, c'est pouvoir résoudre des situations nouvelles.

Le deep learning, et autres machine learning, ce n'est que stocker un maximum d'informations pour savoir quelles sont les meilleurs possibilités d'actions. C'est de la probabilité puissance mille.

Un ia ne fait que ce qu'on lui permet. C'est un algo, rien de plus.

Quand tu réfléchis tu suis des algos aussi patate. "Si je fais truc alors machin". "La fonction est dérivable donc..."

L'ia du go résoud des situations nouvelles, elle a pas appris la totalité des parties de go possible. Elle est pas capable de détecter une tumeur sur une IRM mais ça reste de la généralisation à des situations nouvelles (dans un cadre bien défini).

Tu sors toujours les 2 mêmes "arguments": "c'est des algos", "c'est pas pareil" mais c'est pas des arguments recevable, va falloir que tu le comprennes un jour.

Tout à fait, une morale n'est qu'un ensemble de règles, évolutif au cours du temps et au cours de l'expérience, et influençant la prise de décision

Oui, on fonctionne en partie avec de l'algo, mais va transposer en algo Picasso quand il fait une peinture.

Tu mélanges les concepts.

L'IA du go fait des stats. Il a fait un nombre incalculable de partie, et il sait quand faisant un tel coup, il a 95% de chance de gagner. C'est de l'apprentissage perpétuel.

L'IA du go, à sa première partie, ne savait pas jouer au go. Il avait juste les règles de base, voir pas du tout. Il savait juste quand il gagnait, quand il perdait. A force de partie, il assimile les règles. Après, un million de partie, il peut commencer à jouer correctement, ou presque.

Ce n'est pas une question de résoudre des situations nouvelles. Il ne fait que cela, résoudre des situations nouvelles. A la différence près, qu'à force d'avoir fait des parties, il sait quelles sont les coups gagnant.

Ce n'est pas de l'intelligence, mais de la logique, de la simple stat.

y'a quand même une fonction d'évaluation de position au go, le taf de l'ordi qui calcule c'est pas juste de bêtement tout tester et de voir ce qui gagne tu sais. Il y a tellement de milliards de position possibles que le calcul serait encore trop long et compliqué pour la machine.

que veux tu dire par évaluation de position. Tu dis toi même qu'il y a trop de position possible pour être calculé.

OK alors si je comprend bien ce qui te déranges c'est le fait qu'on ait besoin de donner les règles à la machine afin qu'elle "apprenne" à jouer ? Ce qui te dérange c'est qu'elles ne soient que des calculs de probabilité ?

La question que je te pose est qu'est-ce qui te dit qu'on est si différent ? Un joueur humain qui début aussi n'a aucune idée de quels coups jouer pour se rapprocher de la victoire (au go), mais à force de jouer et de faire des bons ou des mauvais coups il va réévaluer les situations jusqu'à ce qu'il ait des bonnes intuitions sur les bons coups à jouer. Typiquement implicitement il va avoir un truc dans son cerveau lui disant "je peux faire le coup A ou le coup B, alors avec tout l'apprentissage que j'ai et toutes les situations similaires le coup B me paraît être globalement un meilleur coup, peut-être 65% vs 35%, donc il faudrait mieux le jouer"

Moi je vois pas en quoi c'est improbable que ce soit quelque chose du genre qui se passe chez nous, et donc je vois pas en quoi on est si différents.

Sinon un autre truc que les chercheurs ont réussi à faire c'est faire de l'apprentissage non supervisé. On donne seulement beaucoup de données à une machine et on lui demande de s'en faire une représentation compacte. Par exemple à un algorithme nommé word2vec on a donné des milliers de livres à lire en français, il y a donc des dizaines de milliers de mots différents. Mais ce qu'on lui a demandé c'est de représenter ça dans un espace vectoriel à environ 300 dimensions. On appelle cet espace l'espace des sémantiques car à priori il s'agit de l'espace contenant la sémantique des mots donc leur sens. Alors c'est un peu abstrait si t'as pas fait de maths poussés mais en gros c'est un espace dans lequel chaque mot est représenté par un point (pour se le représenter tu peux imaginer que c'est juste un espace à 2D standard c'est équivalent) et ce que les chercheurs ont montré c'est que si tu prends deux mots proches comme chien et chat, alors ils seront proche dans l'espace des sémantiques (plus précisément l'angle entre les deux vecteurs reliant l'origine et les points est très petit). Mieux encore, l'algèbre linéaire permet de faire des opérations mathématiques sur les vecteurs de l'espace des sémantiques. On pourrait penser que ça n'a pas de sens de faire des addition entre les mots, et pourtant lorsqu'on fait ROI - HOMME + FEMME on obtient un nouveau vecteur qui pointe vers REINE.

Comment prétendre que l'algorithme n'a pas saisi ce qu'étaient les concepts cachés derrière les mots.

Enfin une dernière chose, les chercheurs ont fait la même chose en faisant lire à word2vec des livres en anglais qui n'étaient pas des traductions des livres en français et ils ont pareil un espace des sémantiques. Et bien ils ont montré que à une rotation prêt, l'espace des sémantiques était identique à celui en français. Du coup ils ont pris des mots en anglais, ont convertis pour avoir leur représentation sémantique anglaise, ont regardé l'équivalent en sémantique française, puis pris la correspondance dans la langue française et bingo, il s'agissait de vraies traductions correctes de l'anglais vers le français.

Et c'est exactement ce qu'un traducteur humain fait en traduisant : lire un mot ou une phrase en anglais, en extraire le sens ou la sémantique, puis exprimer ce sens en français

Et je rappelle qu'on, les humains, n'a jamais codé le sens d'un seul mot dans la machine mais que celle ci a juste lu beaucoup beaucoup beaucoup

je pense que tu fais référence à cette vidéo : https://youtu.be/n8_zPwh8gMM

Sinon pour ceux que les IA intéressent toute sa série sur le sujet est super intéressante (parfois un peu technique mais si ça vous parle pas vous pouvez passer ces épisodes)

justement, il n'evalue pas la force d'une position (et donc du meilleur coup à jouer) en se fixant sur tous les devenirs possibles de cette position mais en se fixant sur de grands principes. Je ne connais pas assez le go pour être clair mais pour les échecs par exemple, l'ordi est capable de comprendre qu'un fou rayonnant sur une diagonale visant le roi sera bien plus fort qu'un fou en retrait gené par ses propres pions. La machine "comprend" la stratégie d'amélioration de la position qui consiste à placer le fou dans un endroit où il s'exprimera mieux. C'est très loin d'être du calcul de milliards de position différentes sans "réfléchir"

C'est quoi un "algo patate" ? Ou alors... Ou alors tu as déjà décidé que cette discussion n'en était pas une, et que tu pouvais passer en mode "je vous prends bien pour des cons" tout de suite ???

La différence entre un algo et un humain pour une prise de décision ne se situe pas dans le choix final, mais dans la décision du choix. Un humain va faire entrer en jeu un paramètre qu'à ce jour aucune machine ne possède : si cette décision te fait du bien ou du mal.

C'est aussi pour ça que cette notion de bien et de mal n'a aucun sens objectif. Certains se sentent bien quand ils cognent leur femme, d'autres non. De leur point de vue le "bien" c'est quand ils cognent.

Donc tu as un paramètre supplémentaire chez l'humain.

Un algo résoud un problème, c'est tout. Et que l'algo soit auto-généré ne change rien à l'affaire. La machine n'aime pas résoudre un problème, elle le résout, c'est tout.

J'avais écrit un texte de malade pour répondre au précédent com, mais le site a merdé. Mais j'aime ta réponse.

Faut que l'on se mette d'accord sur la définition d'intelligence.

J'avais écrit un texte de malade, ça a merdé. La flemme de réécrire tout.

Word2vec fait ce qu'on luit dit. Tomas Mikolov a écrit un programme. Le programme met en application des principes (comme le Skip Gram Model par exemple). Résultat, tu as un espace vectioriel qui démontre l'analyste sémantique des mots.

Super bluffant au niveau coding. Je te l'accorde ( d'ailleurs, les sources sont ici, c'est intéressant https://code.google.com/archive/p/word2vec/ ). Mais l'intelligence, c'est Tomas qui l'a. Pas le programme. Le programme, il suit juste ses lignes de codes.

C'est la forme super évolué d'une calculatrice, mais cela reste le même principe.

L'intelligence, ce n'est pas cela. L'intelligence, c'est faire face à des situations nouvelles.

Met un être humain dans le froid, avec une pelote de laine, une aiguille et aucune connaissance sur la couture, tu peux être sûr qu'il finira par faire quelque chose qui lui donne chaud.

C'est cela, de l'intelligence.

Le machine learning, et autres, c'est juste la mise en numérique du principe de base de la biologie, c'est à dire d'apprendre de ses erreurs et d'évoluer. Ce que vont tous les êtres vivants depuis la première cellule.

A la différence près, que le machine learning le fait très vite, pour un seul domaine précis. Bref, c'est pas encore parfait.

Faut arrêter avec le terme comprendre. Quand on hardcode une règle, le programme ne comprend pas la règle, c'est de l’anthropomorphisme. Il possède la règle dans son code, c'est tout.

Deep blue, pour prendre référence, ne comprend pas qu'un fou avec le roi en diagonale sera "plus fort" que gêné par des pions.

Il sort juste des integer et des boolean pour définir que c'est un position maximisant ses chances, et il le sait sur base de ce qu'on lui a harcodé, ou qu'il a assimilé lors de ses itérations précédentes.

Mais il ne le "comprend" pas sans avoir les éléments lui permettant d'appliquer la logique adéquate.

La stratégie d'amélioration, c'est juste calculer une position en mémoire, et calculer les coups possibles de l'adversaire.

Stop aussi avec le terme "réfléchir", c'est de l'anthropomorphisme tout autant.

En fait si. C'est même plus subtil que ça, et ça va empirer dans les années à venir. L'intelligence chez les humains c'est savoir utiliser son expérience (innée ou acquise) pour réaliser de nouvelles choses. En détournant l'expérience, en tâtonnant, ce qui renforce l'expérience et permet de réaliser encore de nouvelles choses.

Les IA aujourd'hui sont spécialisées, donc elles sont extrêmement bluffantes dans un domaine donné, et demain on peut tout à fait imaginer qu'en reliant plusieurs IA on donne naissance à une meta IA capable de tout faire.

La partie intéressante c'est de savoir si il y a un "seuil" d'intelligence qui pourrait spontanément faire apparaître une forme de conscience. Est-ce que la conscience est un sous-produit des capacités de nos cerveaux ? Ou est-ce que nos cerveaux sont biologiquement prévus pour de la conscience (auquel cas c'est l'intelligence qui est un sous-produit) ? Dans ce cas aucune conscience numérique ne verra jamais le jour.

On peut maintenant passer au point suivant : si la conscience numérique arrive à émerger, en quoi c'est dangereux pour les humains ? Quelle est la partie "compétition" qui feraient s'affronter les deux camps ?

C'est un débat qui date de Terminator : pourquoi une IA voudrait conquérir la terre ? Ce qui motive les humains c'est l'accès aux ressources modulo les conditions de vie.

Or une IA, même robotisée, n'a pas besoin d'une atmosphère "humains compatibles", elle pourrait migrer sur une planète hostile à l'humanité et nous laisser tranquille.

C'est encore une fois de l’anthropomorphisme : on prête à une IA consciente non seulement la conscience, mais aussi ET SURTOUT de la haine, de la rancune, de la méchanceté, etc. Mais pourquoi ? En quoi ça servirait une IA ? Ces traits de caractères sont inhérent à notre condition biologique : on est compétitifs pour la reproduction et la bouffe. Ce qui pourrait aussi être une condition pour faire apparaître la conscience...

"Tomas Mikolov a écrit un programme. Le programme met en application des principes " ah mais je suis d'accord que les principes sont artificiels et codés par un humain, mais qu'est ce qui te dit que le même genre de principes n'ont pas été codés dans tes cerveau. Que justement l'intelligence et la conscience de manière plus générale est un ensemble de principes qui ont émergés naturellement par la dérive génétique de Darwin ? On parle d'intelligence ARTIFICIELLE pour une raison.

Est-ce que le jours ou les chercheurs arriveront à coder une machine qui arrive à s'adapter au moins aussi bien à des situations nouvelles que l'homme tu diras toujours "mais ce ne sont que des principes codés par l'homme, l'intelligence vient de l'homme pas de la machine" ?

Est-ce que tu penses que le test de Turing n'est pas un test viable pour tester l'intelligence ?

Ou bien es-tu fondamentalement dualiste et selon toi il n'y a aucun moyen que des machines puissent acquérir une conscience/intelligence ?

Si la réponse est non, quel test ou expérience pourrait te convaincre de l'intelligence d'une machine ?

PS : je sais pas pourquoi tu te fais neg, forcément dans des sujets complexes comme celui ci tout le monde a une vision et des connaissances différentes, mais tant que ça se fait dans le respect je comprend pas pourquoi.

Sur Arte j'ai regardé récemment "Italie : "bouton éthique" pour les voitures autonomes".

En gros c'est l'idée qu'un Homme, sur les questions éthiques, configure le comportement d'une machine a priori pilotée par une IA (ici une voiture artificielle qui fait face à un imprévu stye ce que tu décris).

Bouton configuré "altruiste" -> L'IA pénalise la personne dans la voiture et ça te fait foncer dans le mur

" "Impartial" -> Réaction instinctive, l'IA "simule un comportement de surprise"

" "Egoiste" -> L'IA fait en sorte de sauver la personne dans la voiture

Pourquoi je mettrai en doute le terme intelligence où justement ce genre d'ia correspondrai à ma définition de l'intelligence? Parce que je ne suis pas d'accord maintenant? Cela veut dire quoi? Je dois être d'accord avec toi?

Le test de Turing est un test parmi d'autres. Déduire qu'une IA en est une simplement avec cela, c'est incomplet. Pour pouvoir passer le test de Turing, il faut aussi prouver que l'IA génère les phrases suivant le contexte et ne ressorte pas des phrases déjà dites et enregistrée.

Et je suis très sceptique à l'idée qu'une IA puisse avoir une conscience. On ne connait pas assez le cerveau que pour pouvoir répondre à cela. On ne sait pas comment on définit la conscience, comment elle fonctionne, comment elle s'est créée. Alors en créer une nous même. C'est illusoire, pour le moment. (Et franchement, je doute sincèrement que l'économie mondiale le permette un jour..., comme l'éthique d'ailleurs).

Qu'elle puisse s'adapter à des situations dont elle n'est pas sensée être programmée.

Mieux, Une IA qui puisse générer son code voir le corriger. Car c'est cela l'intelligence. S'améliorer, apprendre de ses erreurs, s'adapter à des situations nouvelles.

PS: J'ai l'habitude. Certains ici sont tellement étroit d'esprit qu'il n'arrive pas à accepter l'avis des autres.

"Pourquoi je mettrai en doute le terme intelligence où justement ce genre d'ia correspondrai à ma définition de l'intelligence? Parce que je ne suis pas d'accord maintenant? Cela veut dire quoi? Je dois être d'accord avec toi?" .

Je suis pas sur de comprendre à quoi tu fais référence. En tout cas je cherche pas à te faire changer d'avis mais plutot je cherche à comprendre ton point de vue.

Concernant le test de Turing moi aussi je pensais à première vue que c'était quelque chose de naif et que clairement c'était pas suffisant pour affirmer quoi que ce soit, mais en s'y intéressant de plus près j'ai un peu revu mon jugement. Notamment sur l'histoire du bot qui ressort des phrases préenregistrées, je serais d'accord pour dire que ce n'est pas là une intelligence "consciente". Cela étant dit, il est tout simplement impossible qu'une machine sortant des phrases préenregistrées ne puisse passer le test vu que le test implique des humains qui savent comment piéger un bot. En fait pour réellement passer le test il faut que la machine soit aussi forte en conversation que toi ou moi or là l'argument qui suit logiquement c'est que : qu'est-ce qui te garanti que j'ai moi une conscience ? Bah rien mis à part le fait qu'on arrive à avoir plus ou moins une conversation et que comme tu te dis qu'on a probablement une biologie similaire alors je dois avoir en effet une conscience, mais tout ce que tu fais c'est faire un acte de foi en cette similarité sur la biologie car tu n'as pas accès à ce qui se passe dans mon cerveau. Et bien de la même manière comme on ne peut pas vraiment savoir ce qu'il se passe dans la tête d'une machine, ou même qu'on ne sait pas qu'est-ce qu'on doit chercher.

Une objection faite au test de Turing est souvent "la chambre chinoise" si tu ne connais pas (https://fr.wikipedia.org/wiki/Chambre_chinoise). Mais selon moi cette objection ne tient pas dans la mesure ou la création d'un livre qui donne une réponse à toutes les phrases et dans tous les contextes ne peut pas être créé, et quand bien même on suppose son existence alors rien que le fait de trouver la bonne réponse à donner prendra un temps énorme sans avoir une manière "intelligente" d'explorer le livre.

Bon après je dit pas que le test de Turing est parfait ni suffisant mais il est quand même un argument fort car comme tu le dis toi même, il faut que l'IA "puisse s'adapter à des situations dont elle n'est pas sensée être programmée".

Du coup par rapport à savoir si oui ou non on verra une conscience artificielle apparaître est une question bien sur très compliquée à répondre mais de nombreux experts pensent que c'est pour ce siècle. Personnellement je ne vois pas de raison pour que ce soit impossible, et je ne pense pas que la conscience soit quelque chose de si particulier et incroyable, et même si on n'arrive pas à clairement le définir, ça ne veut pas dire qu'on ne puisse pas en créer une.

Mais je conçois que ce soit dur à imaginer si on a une vision plus dualiste de la conscience (et je juge pas, c'est juste un point de vue avec lequel j'ai du mal à m'accorder)

"Mieux, Une IA qui puisse générer son code voir le corriger. Car c'est cela l'intelligence. S'améliorer, apprendre de ses erreurs, s'adapter à des situations nouvelles."

Des gens travaillent déjà plus ou moins dessus, ils utilisent des réseaux de neurones pour trouver les architectures neuronales optimales.

https://medium.com/@hazemaanomer/why-strong-ai-might-be-impossible-b8e59b73d1fb

Un petit article que je rejoins pas mal.

Je recommande a tous le film 'Ex machina' qui m'a personnellement beaucoup amené a réfléchir sur ce thème.

je confirme ça parle du test de Turing et de la nature de la conscience, et il est pas impossible que ce soit des questions qui vont se poser de notre vivant

le format est sympa, après perso je suis assez friand de vidéos/articles explicatifs en complément du coup si y a moyen de caler ça quelque part je suis plutôt pour

Ouaip ça m'emmerderait aussi que le côté "voilà les sources sur le sujet" prenne le pas sur l'aspect participatif, cela dit s'il y a moyen d'encourager les gens à mentionner leurs sources dans leurs coms par ex ça peut être sympa.

Manque des articles et vidéos pour ceux qui veulent pousser le sujet.

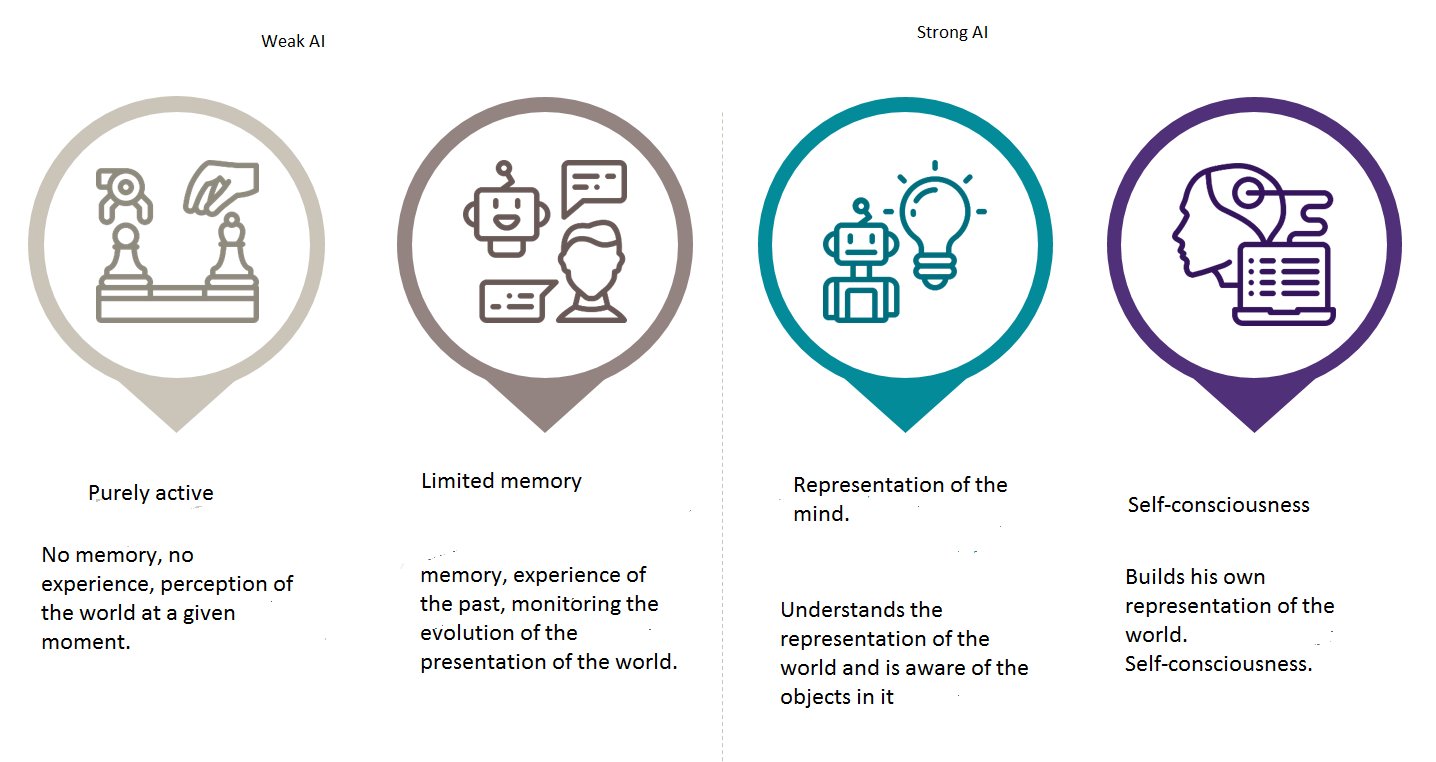

Je trouve ta présentation du sujet à chier, rien que d'oublier de définir le concept de Weak AI et Strong AI changent la donne dans les questions, dire ce n'est pas l'IA, etc. Bref, ce qui donne des questions où on est obligé de réexpliquer des concepts donc aucunes discussions intéressantes.

Peut-être que dans ce cas tu peux faire appel à des "choualexperts" ie des gens un minimum calés dans le domaine, pour faire au moins une relecture de la présentation sinon en faire une de toute pièce. Comme on connait les sujets qui vont potentiellement tomber t'as juste à faire un appel pour que les gens se manifestent

Comment sont balisés les apprentissages en deep learning ? (Jusqu'où peut on laisser une machine apprendre ?)

mon avis, on lui dit quoi apprendre. Et aussi comment (mais beaucoup moins, surtout avec le deep learning)

Je me souviens qu’on avait supprimé une chiee de données à une IA qui avait appris à s´exprimer avec des insultes.

je ne suis pas sur de comprendre ta question. Tu parle d'un point de vue ethique, philosophique, technique ?

D'un point de vue technique, c'est très simple: nous sommes nuls en IA. toutes les publications du niveau "bientot skynet dans votre salle de bains: ca tourne mal", c'est du flan.

Une IA est un objet conceptuel destiné a résoudre un probleme ou un ensemble de problemes. Pour faire très simple, dans un réseau neuronal, chaque neurone a une tache précise a accomplir. Par exemple, pour de la reconaissance d'images, chaque neurone va analyser une portion de l'image et rendre ses conclusions.

Son "apprentissage", c'est de permettre a chaque neurones d'etre confronté au des situations les plus diversifiées possibles pour que la somme des interractions entre le réseau et ce qu'il doit analyser soit suffisement large. Plus le réseau a étudié de situations, plus il sera performant pour analyser une nouvelle situation.

On peut donc bien laisser les réseaux apprendre autant qu'on le veut, ils seront juste plus performants.

Au niveau ethique, je pense que la question ne se pose actuellement pas du tout, nous sommes parfaitement incapables de construire des réseaus suffisement complexes pour qu'une intelligence se construise. Pour le moment, un réseau neuronal, aussi complexe soit il, reste lié a la résolution de taches précises.

Si tu as des questions hésite pas, j'ai des bonnes conaissances techniques et je m'interesse beaucoup aux sujets connexes (ethique, neurosciences, etc)

C'était purement dans le domaine technique, je n'y connais rien du tout, et je me demandais si une machine était capable techniquement d'outrepasser ses fonctions premières à force d'analyses diverses de données.

Y'a pas de règle absolue, globalement créer et entrainer en réseau de neurones c'est autant un art qu'une science.

Y'a deux critères d'arrêt principaux :

En général on observe le taux de réussite en fonction du temps d'apprentissage pour deux types de données:

- les données qui ont servi pour l'apprentissage = base d'apprentissage

- des données de test qui n'ont pas seriv pour l'apprentissage = base de test

Le but c'est que l'IA puisse "généraliser" = réussir sur des données qu'elle a jamais vu avant, donc sur la base de test.

Plus on laisse apprendre plus la réussite sur les données de la base d'apprentissage va augmenter, mais si on laisse trop apprendre la réussite sur la base de test peut finir par diminuer. ça veut dire que l'IA s'est trop entrainé sur ces données et ne marche plus que sur elles, c'est le surapprentissage. En faisant des sauvegarde de temps en temps on peut choisir le point juste avant que ça arrive.

Si ce problème arrive pas, dans tous les cas la vitesse à laquelle l'IA apprend va dimininuer au fur et à mesure qu'elle s'améliore. Au bout d'un moment ça vaut plus la peine d'attendre longtemps pour une toute petite amélioration et on s'arrête.

Merci pour le complément d'infos, ça sous entend donc que l'IA n'apprend que si on l'y autorise, j'y avais même pas pensé tellement c'est logique.

Quand je disais au pif c'était pour dire qu'on lui donne pas juste les données et elle se demmerde. Y'a toujours un objectif à donner pour qu'il se passe quelque chose, ça peut être une mesure de performance plus ou moins sophistiquée mais il faut un moteur à l'apprentissage sinon il se passera rien.

Est-ce que vous pensez qu’une IA peut développer une conscience au bout d’une certaine puissance de calcul acquise ? C’est une question que je me suis toujours posé.

oui, mais c'est plus compliqué que ca.

Il y a deux grandes facons de voir ce qu'est "l'intelligence", "la conscience", "l'esprit": le point de vue dualliste, qui dit que l'intelligence appartient au monde de l'esprit et n'est pas issu de la matiere, et le point de vue materialiste qui dit que l'esprit est entierement issu du materiel. Du point de vue dualliste, c'est totalement impossible: une machine ne peut pas émuler quoi que ce soit dans le monde de l'esprit.

Du point de vue materialiste par contre, c'est tout a fait envisageable.

Sauf qu'avant de réfléchir plus loin, c'est quoi pour toi, la conscience ?

Ça n'a rien à voir avec la puissance de calcul. Mais plus de l'algorithme utilisée pour simuler l'IA.

Ma question est plutôt technique, je suis dev. Python, principalement site, logiciel et script. Et je me suis jamais vraiment lancer dans l'IA. Mais comment ça se goupille niveau technique ? Quand il va "apprendre" comment ça s'passe pour sa persistance d'apprentissage ? En base de donnée ? Si oui, ça doit représenter des BDD démentiel de plusieurs GO non ? Sur la forme, je sais à peu prêt comment ça se goupille, mais dans l'idée, avec ma visualisation actuelle j'me dis que quand j'vois certains réseaux neuronaux ça doit être très compliqué niveau RAM ?

Si tu comptes te lancer dedans je t'invite fortement à avoir une partition swap conséquente .Tensorflow , en c++, par exemple ( et c'est un peu la base) mange plus 16 go juste à la compilation du "modèle" présent sur leurs git :|

Quand tu parles de "compilation" c'est le lancement du process ? Ou la compilation en binaire ? A part le faire fonctionner sur l'ordi d'un ami qui arrivait pas à l'exec, je ne me souviens pas avoir eu de soucis (qui pourtant sont des ordis portable avec 8 go de ram, i5/7 je sais pu)

J'avoue ne pas m'y intéressé présentement, mais risque d'en avoir besoin dans le futur, je peux pas parler du projet car privé, mais en gros j'vais devoir tirer du texte d'image et j'avoue avoir installer un outil en CLI, avec une lib python qui permettait de faire la transition python <-> CLI, mais ça date d'environ 6 mois et je me souviens pas du nom de l'outil en question, c'était un truc open source.

On dérive un peu de ta question initiale. Je t'ai juste présenté une des lib python les plus accessible (à mes yeux) pour faire du Machine Learning. Pour tout le concept du ML et de ses applications courantes, je t'invite à lire les créations des développeurs qui ont utilisé cette techno sur youtube/Google/github etc.

Même si le sujet principal de la box parle de l'IA, il y a énormément de bonnes refs sur internet pour comprendre de quoi on parle :

https://www.youtube.com/watch?v=aircAruvnKk

Ou de quoi s'exercer :

https://playground.tensorflow.org/

Pour les caractéristiques hardware, j'avoue ne pas connaitre grand chose. J'ai surtout constaté la lenteur de l'entrainement avec un processeur "faible". Si tu utilises une carte graphique, certaines sont optimisées (apparemment) pour les calculs d'apprentissage. La RAM ne me semblait pas trop entrer dans les critères important.

La reconnaissance de texte avec son propre modèle d'apprentissage fait-maison, avec un peu de connaissances, ce n'est pas si dur, surtout avec la présence de jeux de données conséquentes (et libres) sur le net. De mon expérience, j'utilisais énormément Jupyter pour tout le confort qu'il peut offrir dans l'aspect recherche du développement de mes algos.

à la compilation en binaire (pour le c++) tensorflow est une monstruosité de consommation de ram . En python ça doit pas poser de problème vu que python ne "compile" pas à proprement parler. Par contre j'ai vu quelqu'un conseiller Keras , effectivement en Python, Keras c'est un confort non négligeable pour l'implémentation des réseaux de neurones.

Pensez-vous que l'apparition de la toute première IA forte, si cela ne relève pas de fiction, marquera un point de non retour dans notre exploration de l'Intelligence Artificielle ? Pensez-vous qu'il serait possible, alors que des IA auront conscience de leur existence et de leur place dans un tout, de les obliger à appliquer les lois de la robotique indéfiniment ?

En théorie rien empêche l'IA forte. En pratique je pense pas qu'on y arrivera.

Pour tout ce qui est machine learning faut donner un but à l'entrainement de l'IA, les lois de la robotique peuvent rentrer dedans a priori. Mais on est tellement dans la spéculation qu'on peut pas dire grand chose de très poussé, on sait pas du tout de quel technique une IA forte pourrait naître.

Si vous voulez savoir ce qui est "techniquement" réalisable pour les plus pointilleux, je peux répondre à pas mal de question étant donné que je participe à des projets utilisant les réseaux de neurones ( Celui sur lequel je travail actuellement c'est répliquer une IA de google mais pour l'utiliser dans des problèmes d'optimisations pour ceux qui connaissent). bon par contre je répond pas dans la minute :)

"des tâches habituellement associées à l'intelligence humaine"--------->Tout détruire autour de soi

(Je peux pas poster de lien, je les ai mis sur etherpad.fr, vous avez juste à taper choual, si quelqu'un avec plus de points peut les poster en réponse.)

Bien que ça enlève un peu du côté participatif, je me permet de mettre un bon article sur le sujet :

Je suis pas forcément d'accord avec tout ce qu'il dit et y a matière à débat mais il démystifie bien le mythe de la singularité et du robot qui arriverait à égaler voire dépasser l'homme au niveau de l'intelligence (tout du moins au niveau de la compréhension du monde qui l'entoure).

C'est une hypothèse qui reste plausible et on a peu de moyens pour la contredire, si ce n'est les possibles limitations technologiques, mais c'est avant tout une hypothèse parmi tant d'autres, et certaines sont bien plus réalistes.

Perso, je trouve assez faux le terme d'intelligence qu'on emploie pour désigner au final de l'informatique avancée. Quand on voit les résultats un peu spectaculaires que l'on obtient avec les joueur de go ou les voitures automatiques grâce notamment au deep learning ça peut faire rêver mais ce sont avant tout des machines avec un objectif d'apprentissage précis. Ça me semble difficile d'introduire une quelconque forme de "volonté" dans un programme informatique et je doute que l'on arrive à avoir des robots comme Gesicht dans le futur.

Je me trompe peut-être, on verra bien, et on peut défendre ou être contre la singularité avec des arguments plus ou moins valides vu que ce n'est qu'une hypothèse.

PS : Carrément hors-sujet du point de vue scientifique, mais une très belle chanson de Scylla sur la singularité du point de vue d'un robot

Question pour saaam (puis d'autres si concernés) : tu as l'air d'en faire et de travailler dessus, sur l'IA. Du coup est-ce par loisir ou est-ce un travail ? Si ça ne te déranges pas, qu'est-ce ce que tu as pu faire en machine learning et est-ce que ça a été concluant ? Sinon quelle a été l'avancée ou la découverte qui t'a le plus impressionné sur le sujet des IA ?

Je fais du traitement de l'image donc ça peut faire parti du boulot mais pour l'instant j'en ai seulement fait en cours et pour le fun.

Le truc le plus intéressant que j'ai fait c'est un réseau de neurones qui donne la carte de relief correspondant à une image. C'est pour pouvoir plus facilement créer des textures pour la 3D et les JV. Ça marche assez bien vu les limitations que j'avais en taille et sur la base de données.

Un des trucs qui m'a le plus impressionné c'est les réseaux adversaires pour la génération d'images. Le principe c'est de mettre deux réseaux en concurrence: le 1er réseau (générateur) apprend à générer des images, le 2eme (discriminateur) apprend à faire la différence entre les images réelles et les images générées. Le générateur essaye de tromper le discriminateur et le discriminateur essaye de pas se faire avoir. Les deux réseaux s'améliorent l'un l'autre et ça permet d'avoir des images générées de largement meilleure qualité. C'est génialement simple et efficace.

C'est cool ça merci du partage !

Quand tu dis la cartes de relief càd que tu donnes une photo plate et que l'IA à l'aide d'indices comme les jeux de lumières arrive à reconstituer le modèle 3D ?

Ouais j'entends souvent parler des GANs car comme c'est de l'apprentissage pas supervisé on a pas besoin de trier les datas au préalable. Mais j'avoue que pour ce qui est de l'architecture du réseau, bien que sur le papier ça a l'air simple j'ai l'impression qu'il y a beaucoup de subtilité qui m'échappe. J'ai failli faire un stage dessus d'ailleurs, sur l'utilisation de GANs pour le traitement de data issus des l'expérience ATLAS du LHC. Mais bon du coup j'en sais pas beaucoup plus.