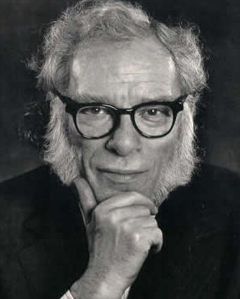

S.H: «L'IA pourrait mettre fin à la race humaine»

Stephen Hawking: «L'intelligence artificielle pourrait mettre fin à la race humaine»

L'astrophysicien britannique Stephen Hawking a averti que le développement de l'intelligence artificielle pourrait signifier la fin de l'humanité. Dans un entretien avec la BBC, le scientifique a déclaré que ce type de technologie pouvait évoluer rapidement et dépasser l'humanité, un scénario comparable à celui des films Terminator ou 2001, l'odyssée de l'espace, ou du roman Robopocalypse.

http://bit.ly/1FLWewg

http://fr.wikipedia.org/wiki/Singularit%C3%A9_technologique

Titre racoleur encore une fois.. Mais le sujet reste interessant je trouve

Si ils pouvaient inventer une femme robot qui fait pas caca , qui n'a pas ses règle ni la migraine ça m'arrangerais.

J'ai scotché une vaginette sur mon grille-pain, tu crois que je devrais déposer un brevet ?

"ce type de technologie pouvait évoluer rapidement et dépasser l'humanité" En meme temps, le niveau moyen de l'humanité est pas bien chouette, ça devrai pas etre difficile.

Ahah n'empeche que d'un autre coté l'accélération technologique se fera dans une certaine partie du monde au détriment d'autres (c'est ce qui est déjà le cas tu vas me dire..)

"la fin de la race humaine"... C'est un peu vague dit comme ça. Déjà, je vois pas pourquoi des robots sur-développés voudraient éradiquer les humains "comme dans Terminator" : une machine même si elle devenait totalement indépendante, à priori, c'est pragmatique, il n'y a aucune raison qu'elle s'attaque à quelque chose qui ne l'atteint pas. Du coup on pourrait comprendre ça dans le sens du transhumanisme, mais ça a pas l'air d'être vraiment le sujet abordé...

Encore une phrase prise au milieu d'une interview pour faire un bon gros clickbait

Techniquement, si cette machine prend des décisions utilisant un système neuronal, elle peut avoir un comportement aléatoire qui la mènerai à tuer un humain. En supposant encore que le comportement des IA se propage par algorithmie génétique, il faudrait que ces dernières soient jugés plus adaptés à la reproduction. Donc scénario catastrophe: Une IA mute aléatoirement et tue un humain. Suite à cet acte, un mouvement extrémiste anti-robot se soulève et commencent un génocide. Les IA qui riposteront et tueront ces humains seront en vie plus longtemps et donc auront plus d'occasion de propager leurs mutations, potentiellement au point de considérer tous les humains comme une menace et de les anéantir.

Ou les humains et les IA vivent plus ou moins en harmonie depuis toujours (y aura toujours des groupuscules anti-IA j'imagine) et les robots ne veulent pas mettre cela en péril pour un simple bug et endigueront d'eux-mêmes le problème avant qu'il ne fasse de dégâts.

Si on parle effectivement d'IA hyper avancée, elles arriveraient de toute façon à éviter toutes les petites mutations plus efficacement que les organismes vivants.

Tout à fait, comme je l'ai dit j'ai sorti le scénario catastrophe :P

Après on peut aussi considérer un algorithme d'IA ou le meurtre d'un humain fait baisser son "score" et la rendrait du coup moins apte à se reproduire, voire lui interdirait complètement la reproduction.

Il n'a jamais dit que c'était certain qu'on serait annihilié, juste que c'est une possibilité à ne pas négliger puisque nous n’avons encore aucune idée de ce que les véritable AI pourraient devenir.

Je trouve ça facile de mettre des images de terminator pour rire de ce qu'il a dit. Il ne faut pas penser dans 20,50 ou 100 ans forcément, rappellons-nous que l'avenir s'étend sur des millénaires et de grâce pas de "ho, mais de toute façon, nous serons tous mort d'ici par un vomi de Gaïa d'ici là".

les commentaires de l'articles sérieux... surtout le premier, le genre de type à qui je balancerai un parpaing dans les dents sans remords.

Je pense que le seul où l'IA sera un danger pour nous c'est quand la solution énergétique sera trouvée. Pour l'instant les IA sont dépendants de nous, ne serait-ce qu'à ce niveau là.

Dans Matrix, les IA étaient dépendantes de l'énergie solaire. Quand les humains ont décidés de couvrir le ciel pour "débrancher" ces machines, elles ont évolués pour utiliser d'autres sources d’énergies (en l’occurrence, des corps humains). Donc même sans solution énergétique il y a une faible probabilité qu'une IA soit capable de devenir complètement indépendante.

Parce qu'elles avaient les capacités d'évoluer. C'est typiquement humain, je ne pense pas qu'un jour elles auront l'intelligence nécessaire pour avoir la capacité de faire évoluer leur "espèce". Ou alors, ce n'est pas demain, et je pense que les humains qui vivront à cette époque là auront toujours un "plan B" pour tout arrêter.

Ne serait-ce que l'IEM.

moi je pense que l'IA on y arrivera jamais vraiment, je veux dire une intelligence qui puisse créer a partir de rien, avoir un opinion, des sentiments, on est loin je crois.

On en est loin, mais avec les développements des algorithmes génétiques et des systèmes neuronaux on s'en rapproche. Google a déjà réussi à créer une IA capable de reconnaître des visages de chat dans des vidéos YouTube, juste en lui apprenant (ce que je veux dire, c'est qu'au départ l'IA ne savait pas reconnaître un visage de chat, et elle a du l'apprendre). Voici le lien de l'article: http://www.tested.com/science/math/44950-what-neural-networks-are-and-how-they-know-the-internet-is-full-of-cats/ . Certes la partie hardware est juste immense pour quelque chose de si petit, mais le hardware a toujours très vite évolué.

Plutôt que Terminator ou 2001, je préférerais qu'on aille plutôt vers du Asimov, ça serait beaucoup mieux...